Hasta hace muy poco, la preocupación de los cibernautas eran las estafas de phishing mediante correos y mensajes de textos. Si bien la sociedad no tardó mucho en reaccionar y aprender a defenderse de ese tipo de delincuencia en línea, los ciberdelincuentes siguen evolucionando y recurren a herramientas que en un principio fueron ideadas para facilitar la vida, como la Inteligencia Artificial (IA). Como si clonar la voz no fuera suficiente, ya se están reportando los primeros estafas con videollamadas usando IA.

Las cifras hablan por sí solas. En 2022, las estafas de impostores fueron el segundo delito más reportado en Estados Unidos, con más de 36,000 informes de personas afectadas por ciberdelincuentes que se hacen pasar por amigos y familiares, según datos de la Comisión Federal de Comercio. Más de 5,100 de esos incidentes ocurrieron por teléfono, lo que representa más de US$11 millones en pérdidas, indica el organismo internacional.

Rostros ¿conocidos?

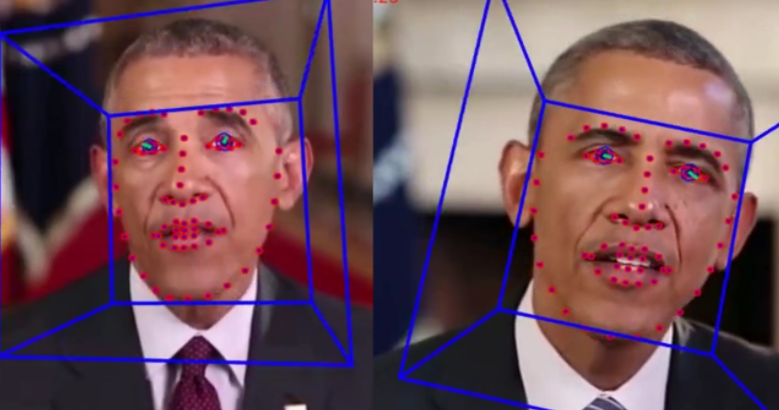

Es un hecho que la tecnología hace que sea más fácil falsificar una videollamada con alguien mediante videos pregrabados o tecnología deepfake, para que parezca que están realizando una conversación cuando en realidad no es así. Lo anterior, como era de esperarse, para manipular al objetivo y que comparta información confidencial, como detalles personales o financieros.

Incluso, el Federal Bureau of Investigation (FBI) emitió una advertencia afirmando que usuarios en internet están utilizando esa herramienta para solicitar entrevistas de trabajos remotas. Esencialmente, fingir una videollamada significa usar un programa o aplicación para alterar lo que muestra su cámara web durante la llamada.

Así como un filtro en Instagram o SnapChat, esta modalidad de estafa puede implicar grabar un video y reproducirlo en lugar de su rostro real. Por ejemplo, cualquiera que esté sentado en una reunión en la que no tenga que hablar podría simplemente reproducir un video de ellos en su pantalla mientras en realidad están haciendo otra cosa.

Un ejemplo es la aplicación ManyCam que permite a los usuarios configurar la entrada de la cámara web en la aplicación de videollamadas que elijan. Es así como reemplazan su cámara de FaceTime o Zoom con un video de YouTube u otro contenido audiovisual pregrabado.

Clase 101 anti-deepfake para evitar estafas por videollamadas

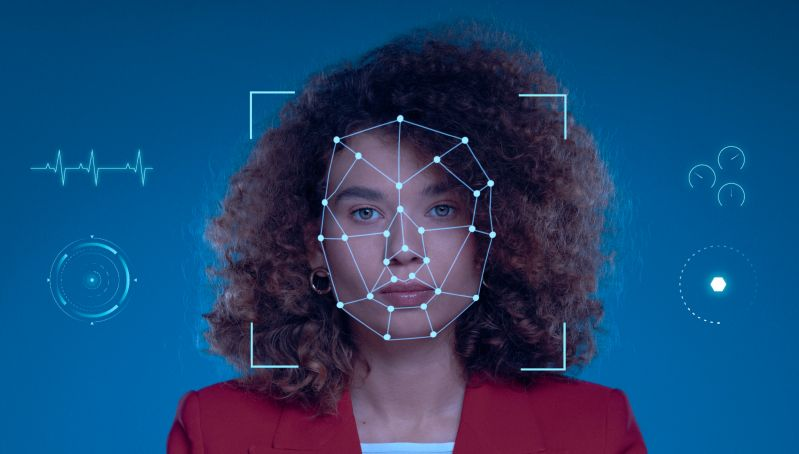

Aunque se vuelve más difícil cuando el objetivo es tener una conversación en vivo con otra persona, la IA está facilitando el proceso. Aun así, hay claves para detectar que se trata de una videollamada falsa. Algunas fallas comunes son:

- Calidad de video. A diferencia de una reunión de cámara web moderna, la calidad de video en un deepfake puede ser deficiente debido a la cantidad de datos que se transmiten. Si parece granulado o el video tartamudea mucho, podría ser un motivo de alerta.

- Cortes y saltos. Si el deepfake tiene dificultades para mantenerse en línea, es posible que la persona salte o se congele momentáneamente.

- Tamaño del video. Cualquier persona que haga una videollamada falsa puede tener que cambiar el tamaño de la ventana de chat para que se ajuste al software que está usando. Si las distorsiones no le parecen bien, puede que sea el momento de sospechar.

- Detalles de contacto. Un indicador podría ser el nombre de contacto de la persona que lo llama. Si no coincide con los detalles que ha guardado, podría tratarse de una llamada falsa.

- Sincronización no coincidente. Si existe alguna duda, se recomienda observar si las partes de video y audio de la llamada se alineen correctamente. Aunque puede darse el caso de una mala conectividad, si los labios de la persona con la que conversa se mueven pero no escuchas nada durante un par de segundos más tarde, podría ser una señal de que se está manipulando lo que está pasando.

Esperemos que nunca seas víctima de estafas por videollamadas, pero en caso de que te topes con algún caso, ya cuentas con las herramientas para detectarlas y protegerte. Recuerda: Navega seguro y no te dejes pescar. ¡Hasta la próxima!